Sıkıştırma

Yandex Araştırmaları LLM’leri Sıkıştırmak İçin Yeni Yöntemler Geliştirerek Yapay Zeka Dağıtım Maliyetlerini 8 Kata Kadar Azalttı

admin

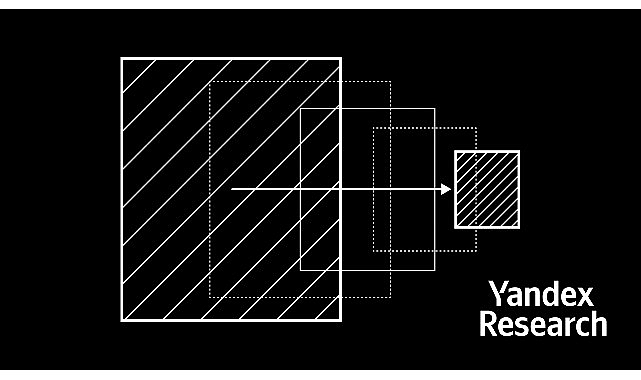

Yandex Research, IST Austria, NeuralMagic ve KAUST, yanıt kalitesini %95 oranında korurken model boyutunu 8 kata kadar azaltan iki büyük dil modeli (LLM) sıkıştırma yöntemi AQLM ve PV-Tuning'i geliştirerek açık kaynak kodlu hale getirdi.